如何打包python爬虫源码?收集依赖项:确定所需的库和数据文件,并创建requirements.txt文件。创建包管理器包:使用pyinstaller或cx_freeze等包管理器打包代码和依赖项,生成可执行文件或压缩文件。

这将生成一个requirements.txt文件,其中包含所有已安装依赖项及其版本。

创建包管理器包:

这将生成一个名为MyCrawler的文件夹,其中包含打包好的可执行文件和依赖项。

Python爬虫源码打包下载

如何打包Python爬虫源码?

打包Python爬虫源码通常涉及以下步骤:

收集依赖项:确定你的爬虫所需的全部依赖项,包括库和数据文件。 创建需求文件:使用pip冻结命令创建一个requirements.txt文件,列出所需依赖项及其版本。 创建包管理器包:使用PyInstaller或cx_Freeze等包管理器,将你的代码、依赖项和必要的资源打包成一青狐资源网wcqh.cn个可执行文件或压缩文件。详细步骤:

立即学习“Python免费学习笔记(深入)”;

收集依赖项: 检查你的代码并确定所需的库,如requests、BeautifulSoup和webdriver。 考虑数据文件,如CSV文件或JSON文件,以及它们的位置。 创建需求文件:在命令行中运行以下命令:

1

pip freeze > requirements.txt

登录后复制

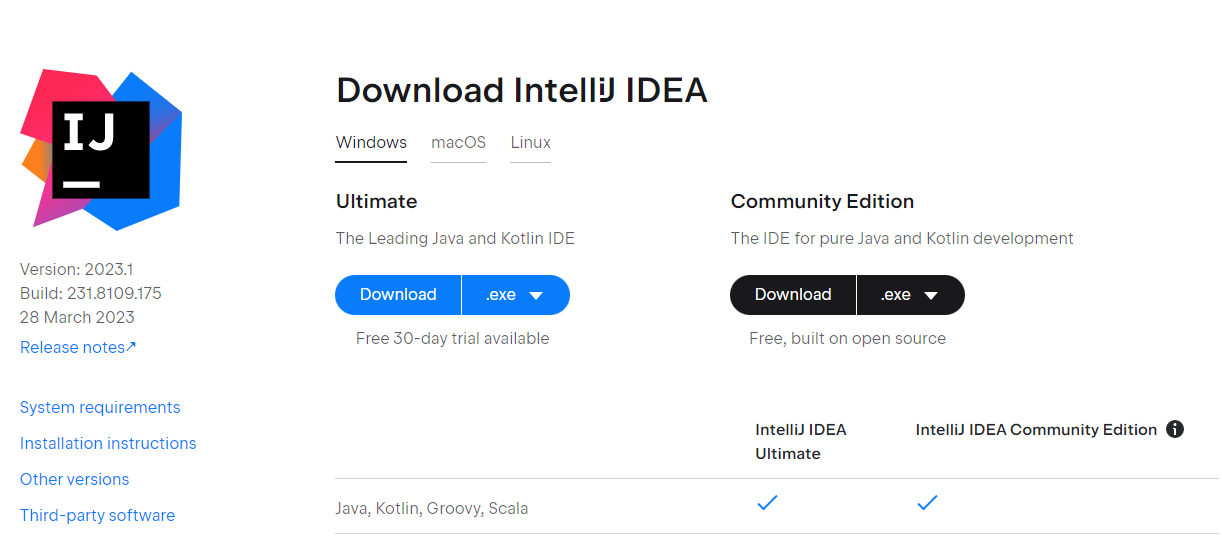

PyInstaller:

安装PyInstaller:pip install pyinstaller运行以下命令:

这将生成一个名为myscript.exe的可执行文件,包含你的代码和依赖项。cx_Freeze:

安装cx_Freeze:pip install cx_freeze创建一个名为setup.py的Python脚本,并添加以下内容:

1

2

3

4

5

6

7

8

9

10

import cx_Freeze

executables = [cx_Freeze.Executable(“myscript.py”)]

cx_Freeze.setup(

name=”MyCrawler”,

version=”1.0″,

d青狐资源网wcqh.cnescription=”My Python crawler”,

executables=executables

)

登录后复制

运行以下命令:

1

python setup.py build

登录后复制

以上就是python爬虫源码打包下载的详细内容,更多请关注青狐资源网其它相关文章!

© 版权声明

1.如需技术支持联系QQ:1339833655

2. 本站所有资源来源于用户上传和网络,如有侵权请邮件联系站长!

3. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

4. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

5. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

6. 如有链接无法下载、失效或广告,请联系管理员处理!

7. 本站资源售价只是摆设,本站源码仅提供给会员学习使用!

8. 如遇到加密压缩包,请使用360解压,如遇到无法解压的请联系管理员!

THE END

暂无评论内容